هوش مصنوعی با سرعتی بیشتر از سرعت پیشرفت انسان، در حال رشد است که این موضوع علاوه بر اینکه بسیار مفید است ولی مشکلاتی را نیز می تواند به وجود آورد. امروزه ما از هوش منصوعی به عنوان یک ابزار باهوش در کنار خودمان استفاده می کنیم و از هوش مصنوعی ایده می گیریم. در بهینه سازی کدها می تواند به ما کمک کند و همچنین در تجزیه و تحلیل داده ها و موارد دیگر استفاده می شود.

نکته منفی در نحوه جمعآوری اطلاعات توسط مدلهای هوش مصنوعی است. ربات های هوش منصوعی تمامی بستر اینترنت را به سرعت کاوش می کنند و با ورود به یک وب سایت دادها های آن را دسته بندی کرده و لینک ها را فهرست می کنند سپس در تمامی لینکها خزش می کنند و تمامی داده های وب سایت را کاوش می نمایند.

البته ربات های موتورهای جستجوگر مانند گوگل نیز به این شکل عمل می کنند ولی خب کار ربات های موتورجستجوگر به نوعی مفید است و باعث افزایش بازدید وب سایت و افزایش کلیک سایت خواهند شد. ولی هوش منصوعی جهت افزایش دانش و بانک اطلاعاتی خود این فرآیندها را اغلب انجام می دهد.

برخی از وب سایت ها قانون کپی رایت دارند و داده های آنها فقط باید با ذکر نام وب سایت منتشر شود و در برخی موارد استفاده از داده های یک سایت توسط صاحب آن مجاز نیست. سوال اینجاست که آیا برای ChatGPT یا Gemini اشکالی ندارد که محتوای دارای حق چاپ را یاد بگیرند و آن را برای کاربران خود دوباره بسته بندی کنند؟

رسیدگی به این موضوع در چهارچوب بحث ما نیست و فقط به عنوان یک مثال مطرح شد که بدانید هوش مصنوعی چگونه اطلاعات جمع آوری می کند و بر اساس الگوهایی این اطلاعات را به دانش تبدیل می کند. خب مزیت وب سایت ها برای هوش منصوعی این است که داده ها به صورت خودکار توسط افراد دسته بندی و مرتبط هستند و مقالات نوشته شده در وب سایت ها علمی و استاندارد است که این خود برای هوش منصوعی منابع قابل اعتمادی را فراهم می کند.

خب حالا شاید از خودتون سوال کنید که چه مشکلی دارد؟ مگر چه می شود که یک ربات هوش مصنوعی داده های وب سایت من را بررسی کند و از آنها یادبگیرد؟

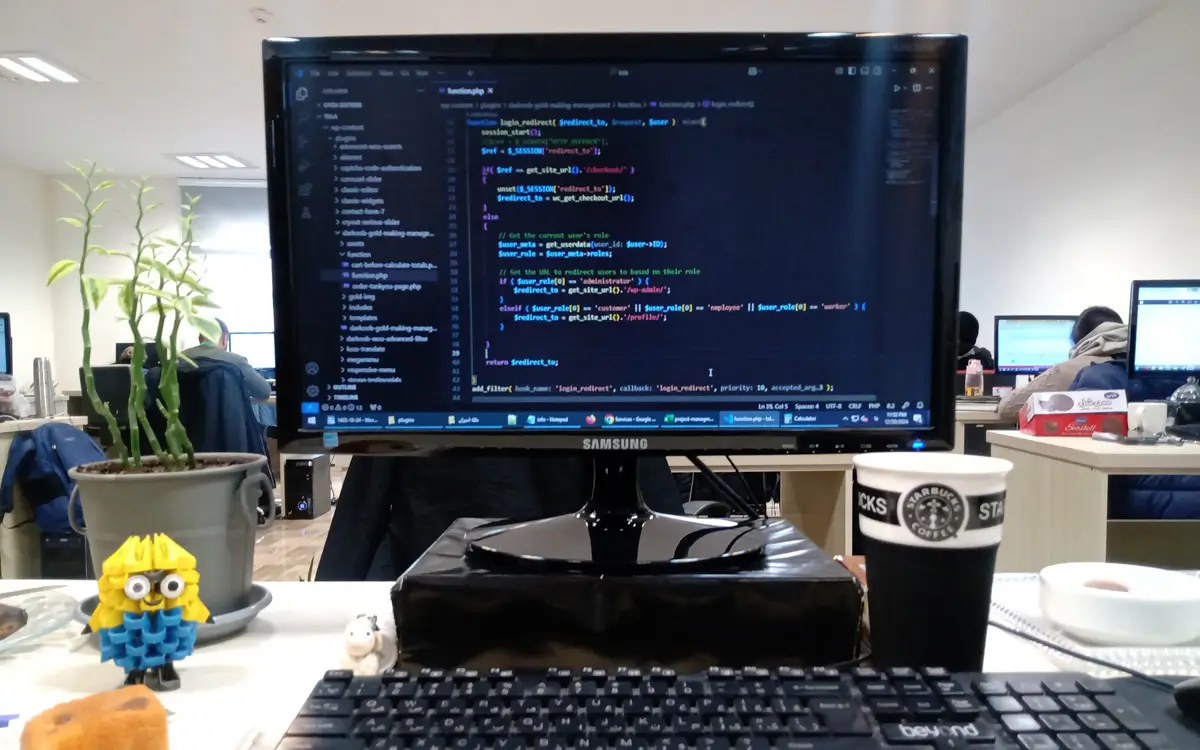

باید گفت از نظر فنی و از دید یک برنامه نویس حرفه ای، وب سایت شما دو نوع کاربر دارد، کاربران عادی که انسان ها هستند و می توانند مشتریان شما باشند که کاربران مفید و مهمی هستند که افزایش آنها هدف اصلی رشد کسب و کار و وب سایت شما نیز می باشد.

نوع دوم ماشین ها (ربات) هستند که برای جمع آوری اطلاعات به وب سایت شما مراجعه می کنند. که این ربات ها نیز می توانند مفید یا مضر باشند. برای مثال ربات های گوگل بسیار مهم هستند و کاوش وب سایت شما توسط این ربات ها نه تنها مضر نیست بلکه کاملاً ضروری است و نباید جلوی آنها گرفته شود. دسته دوم ربات هایی هست که برای حمله کردن به وب سایت ها تولید می شوند و هدف آنها افزایش بی رویه حجم داده های وب سایت و یا از دسترس خارج کردن وب سایت هستند.

یک نوع مضر ربات ها نیز همان ربات های هوش مصنوعی هستند که هدف بدی ندارند ولی باعث افزایش ترافیک بر روی سایت شما می شوند.

ترافیک وب سایت چیست؟

حال که متوجه شدیم ربات ها باعث افزایش ترافیک وب سایت می شوند، باید به این سوال جواب دهیم که ترافیک سایت یعنی چه؟

در دنیای واقعی هر خیابانی یک ظرفیت تعداد خودرو دارد و اگر تعداد اتوموبیل ها از ظرفیت خیابان ها بالاتر برود آنگاه ترافیک به وجود می آید که باعث کند شدن فرآیند رفت و آمد مردم می شود. در دنیای اینترنت نیز هر وب سایت بسته به نوع سخت افزار هاست آن و همچنین زبان های برنامه نویسی به کاربرده شده در آنها، ظرفیت مشخصی برای تعداد درخواست کاربران در ثانیه دارند که اگر تعداد کاربران زیادتر از ظرفیت شود آن سایت یا کند می شود و یا از دسترس خارج خواهند شد.

در وب سایت ها ترافیک را به عنوان پهنای باند در نظر می گیرند و معمولاً به هر وب سایت یک پهنای اختصاص داده می شود که اگر تعداد بازدید سایت بالا رود این پهنای باند نیز کم می شود. مانند حجم اینترنتی که شما می خرید و بر حسب گیگابایت است و اگر شما زیاد از اینترنت استفاده کنید حجم شما نیز سریعتر تمام می شود.

برای مثال اگر وب سایت شما برای لود شدن 2 مگابایت از حجم اینترنت یک کاربر را ببرد، آنگاه اگر در روز شما 1000 کاربر داشته باشید حدود 2 گیگابایت از ترافیک سایت شما کم می شود. حال اگر از این 1000 بازدید، فقط 10 عدد از آنها کاربر باشد و 990 تای آنها ربات باشد آنگاه شما در حال ضرر کردن هستید. تقریباً همه بازدید کنندگان شما ربات هستند و ربات ها از شما خرید نمی کنند.

هر وب سایت و کسب و کاری به دنبال افزایش ترافیک کاربرانش است و می خواهد مشتریان بیشتری داشته باشد تا درآمد زیادی کسب کند. ولی اگر بیشتر این ترافیک مشتری واقعی نباشد و ربات ها باشند آنگاه این ترافیک نه تنها سود آور نیست بلکه مشکل جدی خواهد بود.

همانطور که گفته شد برخی از ربات ها به عمد جهت افزایش ترافیک وب سایت ها و مختل کردن آنها توسط هکرها ایجاد می شوند. برای مثال فرض کنید ثبت نام برای کنکور قرار است فردا شروع شود و کاربران برای ثبت نام باید به سایت مربوطه مراجعه کرده و به صورت آنلاین ثبت نام کنند. حال یک گروه هکری یک سری ربات را تولید می کنند که در روز ثبت نام ترافیک وب سایت را بالا ببرند و به این شکل باعث کند شدن یا از دسترسی خارج شدن وب سایت می شود.

ولی هدف ربات های هوش مصنوعی افزایش ترافیک نیست، بلکه هدف آنها افزایش دانش هوش مصنوعی است ولی ناخواسته ترافیک سایت ها را نیز بالا می برند. برای مثال سایتی مانند ویکی مدیا که ویکی پدیا معروف یکی از زیر مجموعه های آن است اعلام کرده که حدود 50% از ترافیک آنها توسط هوش مصنوعی اشغال شده است.

با مواردی که تا اینجا بررسی شد، می توانیم این نتیجه را بگیریم که هوش مصنوعی می تواند ترافیک سایت را اشغال نماید. حال باید از خود بپرسم که راه حل چیست و چگونه فرق بین ربات هوش مصنوعی و ربات های مفید گوگل را تشخیص دهیم؟

آیا مسدود کردن ربات های هوش مصنوعی کار راحتی است؟

در وب سایت ها این امکان وجود دارد که ربات ها یا آی پی های خاصی را مسدود نماید. به زبان ساده می توانید تعیین کنید وب سایت شما برای چه آی پی قابل دسترسی نباشد. یک فایل به اسم robots.txt باید به ریشه وب سایت درون هاست اضافه شود و درون آن تنظیماتی برای دورنگه داشتن ربات ها اضافه شود. و ربات ها وقتی وارد یک وب سایت می شوند ابتدا این فایل را بررسی می کنند و ربات ها نیز مجبورند به این دستورات توجه کنند. البته بستگی به سازنده ربات ها دارد.

برای مثال شرکت هایی مانند گوگل ربات ها را طوری برنامه ریزی می کنند که ابتدا محتوای فایل robots.txt را مشاهده کنند و در صورتی که طراح و صاحب وب سایت اجازه داده بود آنگاه وب سایت را کاوش کنند در غیر اینصورت وب سایت را بررسی نمی کنند. ربات های مخرب و همچنین برخی از شرکت های هوش مصنوعی به robots.txt توجه نمی کنند و در هر صورت وب سایت شما را کاوش می کنند و این نشان می دهد که robots.txt راه حل نهایی نیست و فقط برخی از ربات ها را محدودتر می کند.

یک راه دیگر بلاک کردن آی پی ربات ها هستند. ببینید هر ماشین (کامپیوتر) در شبکه اینترنت یک آی پی منحصر به فرد دارد مانند پلاک خودرو که هر خودرو یک شماره پلاک اختصاصی دارد و دو خودرو یک پلاک مشترک ندارند و یا مانند شماره موبایل افراد که کاملاً شخصی و اختصاصی است. بنابراین اگر ما شماره IP یک ربات را بلاک کنیم آن ربات دیگر نمی تواند وارد سایت ما شود.

درون هاست سایت، جایی که کدهای سایت قرار دارند، یک فایل وجود دارد به اسم .htaccess که کاربرد بسیار زیادی دارد و یکی از موارد آن تعریف لیست IP های غیرمجاز است که کمک می کند ما فهرست آی پی های را به آن داده و از ورود غیرمجاز آنها جلوگیری کنیم.

یک چالش دیگر وجود دارد و آن هم این است که شرکت های سازنده هوش مصنوعی هرکدام ارتشی از ربات ها را در اینترنت رها می کنند و مقابله با آنها که دائماً در حال تغییر هستند نیازمند رسد دائمی توسط طراح را دارد. یعنی به صورت مداوم میزان بازدید زیاد توسط یک IP خاص بررسی شود و اگر غیرعادی بود آن را به لیست بلاک ها اضافه نمایم. ولی خب این راه حل نیز یک راه حل بهینه نیست و زمانبر است.

خبر خوش این است که برنامه نویسان و توسعه دهندگان به این موضوع فکر کردن و ابزارهایی را برای مقابله با این موضوع ایجاد کرده اند که می توانیم از آنها بهره ببریم و خیال خود را راحت کنیم.

سه روش برای مسدود کردن رباتهای مزاحم هوش مصنوعی

اگر دیدید که ترافیک وب سایت شما به صورت ناگهانی زیاد شده به احتمال زیاد توسط ربات ها در حال کاوش است. در برخی از وب سایت ها ابزاری وجود دارد که به شما تعداد بازدید ها را در روز نمایش می دهد. همچنین بیشتر هاست ها نیز ابزاری دارند که میزان بازدید وب سایت شما را به صورت روزانه نمایش می دهد و حتی نمایش می دهد که از کدام کشور و با چه آدرس IP وب سایت شما مشاهده شده و حتی کدام IP چه مقدار داده از سایت شما مشاهده کرده است.

اگر یک IP در طول روز مقدار قابل توجهی داده بر حسب مگابایت از شما مشاهده کرده بود آنگاه بدون شک آن انسان نبوده و یک ربات (ماشین) بوده. در ادامه چند ابزار برای مسدود کردن ربات های هوش مصنوعی معرفی می کنیم. ولی باید به این نکته تجوه داشته باشید که هیچکدام از راه حل ها 100% نیست ولی بسیار موثر هستند.

استفاده از فایل ai.robots.txt

در اینجا یک راه حل دستی برای مسدود کردن رباتها ارائه شده است که میتوانید با هر وبسایتی از آن استفاده کنید. این یک لیست باز از خزندههای وب است که به مدلهای هوش مصنوعی تعلق دارند. این لیست به طور مرتب بهروزرسانی میشود تا رباتهای جدید را به محض آنلاین شدن در بر بگیرد. در زیر لینک صفحه کدهای این برنامه قرار داده شده که می تواند کاربردی باشد:

افزونه بلاک کننده ربات های هوش منصوعی

افزونه Block AI Crawlers یک افزونه وردپرس است که به طور خودکار فایل سایت شما را اصلاح میکند robots.txt. آن را نصب کنید و رباتهای هوش مصنوعی شناخته شده را با یک کلیک مسدود کنید. این یک ابزار مفید برای سایتهای وردپرس است زیرا رباتهای جدید را میتوان از طریق بهروزرسانیهای افزونه اضافه کرد. این امر بار مسئولیت صاحبان وبسایت را کاهش میدهد.

تله کلودفلر (cloudflare) برای هوش مصنوعی

راه حل شرکت کلودفلر برای مبارزه با رباتهای هوش مصنوعی، استفاده از هوش مصنوعی مولد است. ابزار هزارتوی هوش مصنوعی آنها زمانی که خزش غیرمجاز یک سایت را تشخیص میدهد، وارد عمل میشود. این ابزار، ربات متخلف را به مجموعهای از محتوای تولید شده توسط هوش مصنوعی هدایت میکند. از آنجا، ربات زمان و منابع خود را صرف اسکن صفحات وب جعلی میکند.

در واقع کلودفلر یک شبکه تحویل محتوا است که بین وب سایت شما و بازدید کنندگان قرار می گیرد. حال اگر تشخیص دهد که کاربر شما ربات است آن را به وب سایت شما هدایت نمی کند، بلکه ربات را به دام می اندازد و آن را به صفحات تقبلی که با هوش مصنوعی ساخته شده هدایت می کند و به این صورت ربات را در یک هزارتو محتوای ساخته شده با خود هوش مصنوعی گیر می اندازد. و به این روش سایت شما در امان می ماند.

این شرکت همچنین از این تله برای شناسایی بازیگران بد استفاده میکند. آنها را به فهرستی اضافه میکند که میتوان آنها را برای همیشه مسدود کرد. این یک ابزار خودکار است و نیازی به پیکربندی ندارد. کاربران Cloudflare میتوانند آن را فعال کرده و خیالشان راحت باشد.

uxweb

uxweb